La startup de inteligencia artificial (IA) china DeepSeek ha irrumpido recientemente en los mercados con el lanzamiento de un modelo de IA innovador y rentable llamado R1. DeepSeek-R1 rivaliza con modelos más caros como ChatGPT de OpenAI. Además, demuestra que el desarrollo de una IA avanzada no requiere necesariamente una enorme inversión.

Está claro que la eficacia modelo de IA de DeepSeek tiene potencial para ampliar la adopción de la IA. Sin embargo, también ha causado preocupación por lo que el gobierno chino hará con los datos que recopile. Las organizaciones tienen motivos para preocuparse de que sus usuarios puedan exponer datos sensibles de clientes, sus algoritmos patentados o sus estrategias internas.

La exposición de datos de identificación personal (PII) puede dar lugar al incumplimiento del RGPD que podrían tener graves consecuencias económicas. Las multas impuestas por el RGPD pueden ascender a 20 millones de euros o al 4 % de los ingresos anuales globales de una empresa, la cantidad que sea mayor. Además, puede causar daños a la reputación y una pérdida de confianza de los clientes.

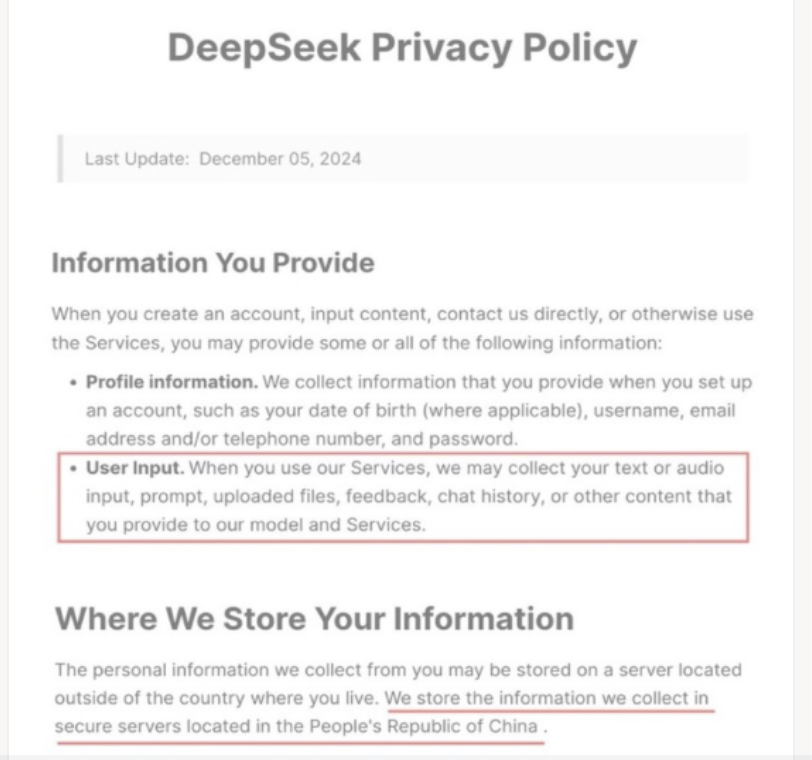

La política de privacidad de DeepSeek no ayuda a aliviar estos temores. Basta con considerar la siguiente declaración:

Política de privacidad de DeepSeek.

Para mitigar estos riesgos, las organizaciones deben adoptar un enfoque integral que abarque a las personas, los procesos y la tecnología. No solo deben implementar tecnología que proporcione controles de acceso y datos centrados en las personas, sino que también deben establecer políticas internas sólidas y consejos de gobernanza de la IA para su supervisión y orientación. Necesitan poder supervisar el uso de la IA y el acceso a los datos. Y deben contar con medidas como la formación de los empleados y un marco ético sólido.

Seguridad centrada en las personas para la IA generativa

La adopción segura de herramientas de IA generativa es una prioridad para la mayoría de los CISO. Proofpoint cuenta con una plataforma centrada en las personas para la seguridad de los datos adaptable, que puede ayudar. Nuestra solución le proporciona visibilidad y control para IA generativa (GenAI) en toda su organización.

A diferencia de las soluciones DLP heredadas y el filtrado web que bloquean todo uso de las aplicaciones de IA generativa, Proofpoint puede permitir, orientar y restringir selectivamente su uso en función del comportamiento de los empleados y del contenido que introducen.

Con Proofpoint Enterprise DLP, Data Security Posture Management y ZenGuide, podemos ayudarle a hacer cumplir las políticas de uso aceptable de las herramientas de IA generativa públicas, así como de los copilotos empresariales y los grandes modelos de lenguaje (LLM) personalizados.

A continuación incluimos una lista completa de lo que puede conseguir con Proofpoint:

Obtenga visibilidad de las herramientas IA generativa no autorizadas:

- Realice un seguimiento del uso de más de 600 sitios de IA generativa por usuario, grupo o departamento.

- Supervise el uso de aplicaciones de IA generativa con contexto sobre el riesgo del usuario.

- Identifique y alerte sobre autorizaciones de aplicaciones de IA de terceros para acceder al correo electrónico, el calendario y los datos en la nube del usuario, etc.

Aplicar políticas de uso aceptable de las herramientas de IA generativa:

- Bloquee las carga web y el pegado de datos sensibles en sitios de IA generativa.

- Evite que se introduzcan datos confidenciales en herramientas como DeekSeek, ChatGPT, Gemini, Claude y Copilot, o reduzca los datos confidenciales que se introducen en las solicitudes de inteligencia artificial mediante nuestra extensión para navegador.

- Revoque o bloquee autorizaciones para aplicaciones de IA generativa de terceros.

- Supervise y reciba alertas cuando Copilot para Microsoft 365 acceda a archivos confidenciales a través de mensajes de correo electrónico, archivos y mensajes de Teams.

- Detecte, etiquete y proteja los archivos que contengan datos confidenciales, incluidos los contenidos generados por IA.

Supervisar las amenazas internas con políticas para IA generativa dinámicas:

- Capture de metadatos y capturas de pantalla antes y después de que los usuarios accedan a las herramientas de IA generativa.

Evitar la exposición de datos a copilotos de IA y a grandes modelos de lenguaje personalizados:

- Clasifique los datos y gestione el acceso a los mismos mediante aplicaciones de IA como Copilot para Microsoft 365 para garantizar que el contenido generado por IA no exponga datos confidenciales.

- Proteja los modelos de IA fundacionales o personalizados, incluidos los de DeepSeek en AWS Bedrock y Azure OpenAI para que no se entrenen con datos confidenciales.

- Realice análisis de sensibilidad casi en tiempo real del uso de datos por parte de las plataformas de IA generativa.

Formar a los empleados sobre el uso de herramientas de IA generativa:

- Forme a los usuarios sobre el uso seguro de IA generativa con vídeos, carteles, módulos interactivos y boletines informativos.

- Automatice la formación personalizada para sus usuarios de mayor riesgo.

Seguridad de los datos en sintonía con las nuevas herramientas de IA generativa

Proofpoint se compromete a supervisar continuamente el mercado de la IA generativa y a mantenerse al día de las nuevas herramientas de IA. Nuestro enfoque arquitectónico nos permite innovar rápidamente y desplegar nuevas funciones sin apenas afectar a la productividad de los usuarios. Por ejemplo, una de nuestras soluciones DLP es una extensión de navegador que evita la pérdida de datos a través de los envíos de prompts de IA generativa. Esto nos permitió responder rápidamente a DeepSeek.

El lanzamiento de DeepSeek-R1 se produjo el 20 de enero. Y el 30 de enero Proofpoint ya tenía la capacidad de aplicar políticas de uso aceptable para DeepSeek y prevenir la pérdida de datos. Una vez implementada la extensión de navegador de Proofpoint para DLP, no es necesario realizar más cambios de configuración ni actualizaciones de software. Enviamos las actualizaciones a través de nuestro backend a la extensión del navegador. Esto permite que ofrezcamos cobertura rápida y transparente de nuevos sitios como DeepSeek.

Más información

Para conocer el nivel de las funciones de DeepSeek respecto a otros modelos de IA, vea nuestro webinar “DeepSeek y lo que depare el futuro: cómo reforzar la seguridad de los datos en la era de la IA generativa”, que se celebró el martes, 11 de febrero de 2025.

Para ver una demostración de nuestras soluciones de seguridad de los datos para la IA generativa, vea nuestro webinar “Defender los datos: Innovaciones” el martes 18 de febrero de 2025.

Póngase en contacto con el responsable de su cuenta para descubrir cómo puede ayudarle Proofpoint a implementar políticas de uso aceptable para herramientas de IA generativa y realizar una prueba de nuestra solución.