Você provavelmente já sabe que a inteligência artificial generativa (GenAI) é uma faca de dois gumes — ela apresenta tanto oportunidades quanto riscos. Por um lado, a GenAI melhora a produtividade, especialmente no que se refere a criação de conteúdo, solução de problemas, pesquisa e análise. Por outro lado, ela gera vários riscos de segurança que as pessoas ainda não assimilaram completamente.

Nesta postagem de blog, vamos explorar os riscos mais comuns associados à inteligência artificial generativa, para que você possa educar devidamente os seus usuários.

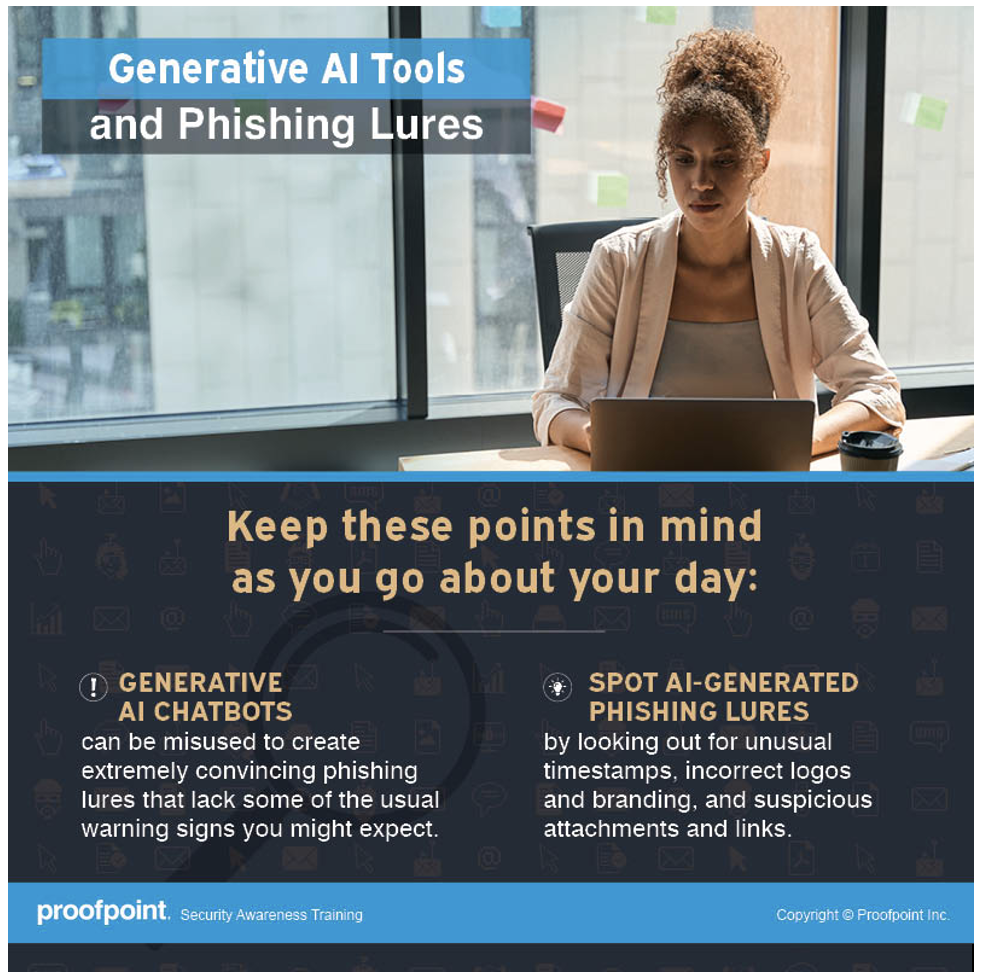

A GenAI é utilizada para criar iscas convincentes

Os criminosos cibernéticos certamente são beneficiados pela GenAI, pois ela os permite superar barreiras de idioma e até mesmo culturais. Pesquisas para o relatório State of the Phish de 2024 da Proofpoint revelaram que os ataques de comprometimento de e-mail corporativo (BEC) tornaram-se mais comuns em países não falantes de inglês. Uma das razões dessa tendência é a ascensão da GenAI.

Antigamente, dizíamos às pessoas que prestassem atenção a erros gramaticais e ortográficos nos e-mails porque estes eram indícios óbvios de phishing. Agora não é mais assim.

Com a GenAI, as mensagens de phishing ficaram bem mais elaboradas. Erros gramaticais não são mais um forte indicador de phishing. Pesquisadores de ameaças podem argumentar que as mensagens de phishing mais sofisticadas ainda são criadas manualmente por malfeitores. Atualmente, porém, os adversários aproveitam o poder da GenAI para aumentar o volume, a escala e a sofisticação de seus ataques.

O que o seu pessoal deve saber

Não confie em remetente algum, mesmo que o e-mail pareça vir de alguém que você conhece ou de alguma autoridade. Preste muita atenção a outros indícios de phishing, como um senso de urgência, um remetente inesperado, discrepâncias entre o nome de exibição e o endereço de e-mail do remetente e solicitações de pagamento ou de dados confidenciais.

Um infográfico sobre GenAI e iscas de phishing disponibilizado com o Proofpoint Security Awareness.

A GenAI pode ser uma fonte de vazamentos de dados

Para aumentar a produtividade, algumas pessoas fazem upload de seus trabalhos para sites de GenAI em busca de análise de dados ou de assistência técnica ou editorial. Ocasionalmente, seu trabalho envolve informações confidenciais, como código-fonte, informações de clientes ou um processo de produção ou receita secreta.

A maioria das pessoas não está ciente de que esses sites de GenAI ou chatbots de inteligência artificial podem armazenar qualquer informações compartilhadas com eles. Desenvolvedores treinam os chatbots de inteligência artificial com as entradas e respostas dos usuários para melhorar seu desempenho. Consequentemente, esses chatbots podem compartilhar acidentalmente dados confidenciais com outros usuários, dentro ou fora da sua organização, resultando em possíveis violações de dados e constituindo risco para propriedade intelectual (IP).

O que o seu pessoal deve saber

Tudo o que você compartilha com um chatbot de GenAI público pode ser compartilhado com outros. Tenha cuidado para não compartilhar informações confidenciais e não fazer upload de dados confidenciais para um site de GenAI. Isso pode resultar em perda de propriedade intelectual, descumprimento de regulamentos e violações de dados.

Alucinações de GenAI significam resultados nem sempre confiáveis

Os chatbots de GenAI parecem saber TUDO. Quando você faz uma pergunta, eles sempre produzem respostas que parecem fazer sentido. Porém, quando um chatbot é treinado com dados imprecisos ou tendenciosos, qualquer informação gerada por ele pode ser de fato errada. Por exemplo, imagine um chatbot de inteligência artificial treinado com dados que sugerem que a terra é plana.

Os modelos de inteligência artificial são treinados com dados para encontrar padrões e para fazer previsões. Se um chatbot de inteligência artificial for treinado com dados incompletos ou tendenciosos, ele identificará padrões incorretos e gerará informações imprecisas, incompletas ou tendenciosas. Isso é o que chamamos de alucinação da inteligência artificial. Entre exemplos comuns, podemos citar:

- Informações comprovadamente incorretas. O texto ou a afirmação gerada por um chatbot de inteligência artificial parece verdadeira quando não é (ou é parcialmente verdadeira). Essa é uma das formas mais comuns de alucinação de inteligência artificial.

- Informações falsas. A GenAI gera informações falsas sobre uma entidade ou pessoa real, incluindo fragmentos de informações falsas. Alguns usuários podem aceitar essas respostas fabricadas como verdadeiras.

- Falta do contexto completo. Um chatbot de inteligência artificial pode gerar uma afirmação genérica sem dar aos usuários todas as informações de que estes necessitam. Por exemplo, se alguém pergunta se é ou não seguro comer manteiga de amendoim, o chatbot pode não fornecer detalhes suficientes, como o risco de uma reação alérgica aos amendoins, que ajudariam a pessoa a tomar uma decisão consciente.

O que o seu pessoal deve saber

Seja cético em relação a todas as informações oriundas de um chatbot de inteligência artificial. Faça sua própria pesquisa com outras fontes e confira a veracidade de tudo o que os chatbots alegam ser verdadeiro. Além disso, lembre-se de que muitos chatbots de inteligência artificial não foram projetados para usos específicos, como realizar pesquisas científicas, citar leis e precedentes ou prever o clima. Você obterá uma resposta, mas ela pode não ser precisa.

A GenAI facilita a criação de deepfakes

Deepfakes são imagens ou vídeos falsos gerados por inteligência artificial e manipulados para substituir o rosto ou a voz de uma pessoa. Eles são gerados por um tipo de autoaprendizagem chamado deep learning (aprendizagem profunda). Embora os deepfakes tenham surgido antes da popularização das ferramentas de GenAI, estas ferramentas tornam muito fácil a criação de deepfakes porque a GenAI utiliza algoritmos para gerar conteúdo com base em exemplos e dados existentes.

Os deepfakes tornaram-se uma arma poderosa para criminosos cibernéticos lançarem ataques, especialmente contra grandes empresas. Os atacantes podem, por exemplo, se fazerem passar por executivos, como o CEO ou o CFO da empresa, utilizando deepfakes para autorizar pagamentos fraudulentos.

Tecnologias emergentes como a GenAI tornam a criação de deepfakes mais fácil e mais econômica, portanto, é mera questão de tempo para que atacantes comecem a visar empresas de todos os portes. Infelizmente, não existe uma tecnologia ou solução que possa efetivamente detectar e bloquear deepfakes maliciosos. A melhor aposta é educar os seus funcionários sobre deepfakes, estabelecer um processo interno e criar políticas de mitigação.

O que o seu pessoal deve saber

Sempre confirme a solicitação com o solicitante por meio de um canal diferente. Quando pessoas recebem uma chamada telefônica ou de vídeo de um líder ou profissional conhecido pedindo-lhes que façam alguma coisa imediatamente, é recomendável confirmar com essa pessoa por meio de uma linha telefônica direta (pessoalmente, se possível).

Moral da história: não confie em ninguém. Use de bom senso. Se algo parecer estranho, informe à equipe de segurança.

Um infográfico sobre deepfakes gerados por inteligência artificial disponibilizado com o Proofpoint Security Awareness.

Faça da educação do usuário uma parte da sua iniciativa de segurança

Diz um velho provérbio chinês: “A água que sustenta o barco também pode naufragá-lo”. Em nosso mundo atual, há muito entusiasmo com a conveniência que a GenAI traz e com o futuro promissor que ela parece anunciar. Contudo, é fundamental não desprezar os riscos associados a essa tecnologia que se dissemina tão rapidamente.

Ao definir as estratégias e prioridades das suas iniciativas de segurança para lidar com os riscos da GenAI, certifique-se de que a educação do usuário seja parte do plano. Com a adoção mais ampla dos chatbots de inteligência artificial, os seus funcionários precisam conhecer as vantagens e os riscos da GenAI para que possam proteger melhor a si próprios e à sua empresa.

O mês da conscientização quanto à cibersegurança está chegando. Comece já a planejar e não deixe de incorporar os riscos da inteligência artificial generativa no seu programa. Para saber mais sobre como promover uma cultura de vigilância que transforme as pessoas, de alvos passivos em defensores ativos, junte-se a nossa série especial de webinars, de 14 a 28 de agosto.