Vermutlich wissen Sie bereits, dass generative KI (GenAI) ein zweischneidiges Schwert ist, das sowohl Chancen als auch Risiken birgt. Sie verbessert die Produktivität, insbesondere bei der Erstellung von Inhalten, Fehlerbehebung, Forschung und Analyse, ist jedoch auch mit zahlreichen Sicherheitsrisiken verbunden, die noch nicht im Bewusstsein der Menschen angekommen sind.

In diesem Blog-Beitrag erläutern wir die wichtigsten Risiken bei generativer KI, damit Sie Ihre Anwender entsprechend schulen können.

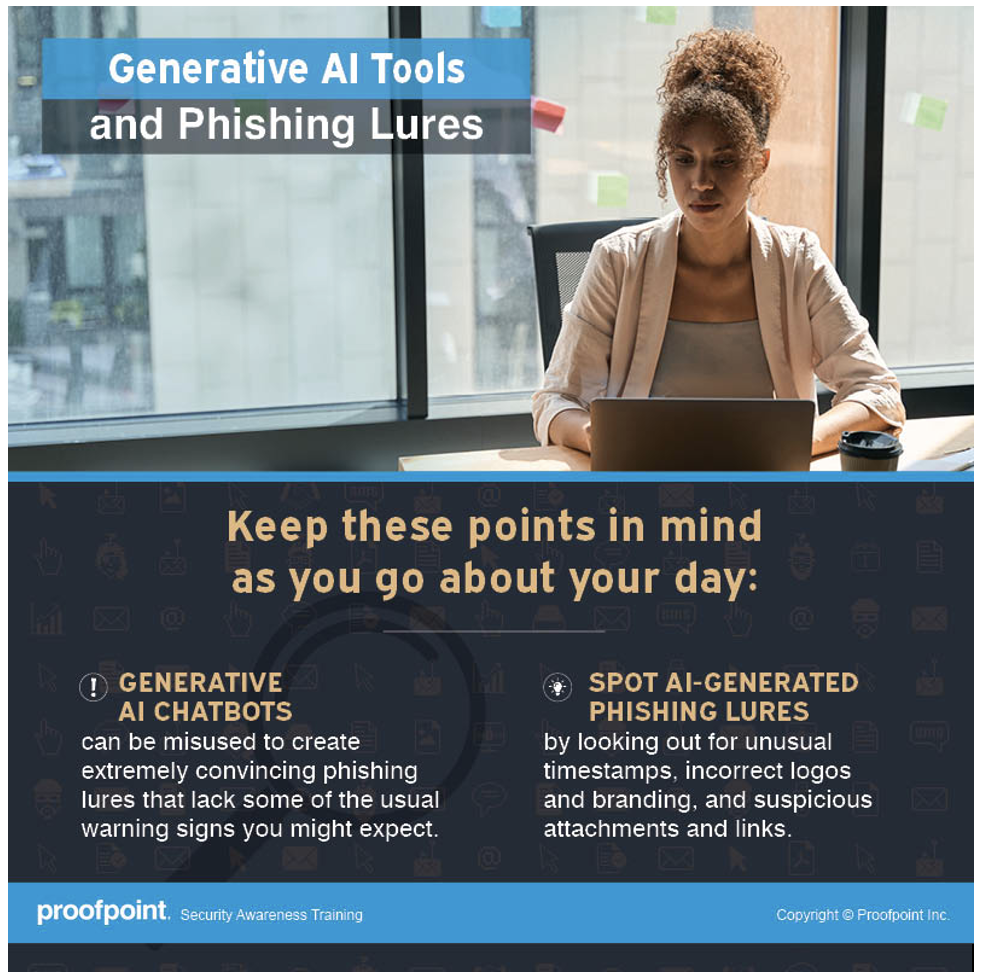

Generative KI wird zur Erstellung überzeugender Köder genutzt

Für Cyberkriminelle stellt generative KI ein besonders wertvolles Hilfsmittel dar, da sie damit sprachliche und sogar kulturelle Barrieren überwinden können. Die Untersuchungen für den Proofpoint-Bericht State of the Phish 2024 zeigen, dass die Anzahl von BEC-Angriffen (Business Email Compromise) in nicht englischsprachigen Ländern wächst. Ein Grund für diese Entwicklung ist die zunehmende Nutzung generativer KI.

Früher haben wir Mitarbeitern beigebracht, bei E-Mails auf schlechte Grammatik und Rechtschreibfehler zu achten, da dies klare Anzeichen für einen Phishing-Versuch waren. Heute ist dies überholt.

Dank generativer KI hat sich die Qualität von Phishing-Nachrichten deutlich verbessert, sodass Rechtschreibfehler kein klares Indiz für Phishing mehr sind. Bedrohungsforscher würden anführen, dass besonders raffinierte Phishing-Nachrichten nach wie vor manuell erstellt werden. Allerdings nutzen die Angreifer nun die Vorteile von GenAI-Tools, um die Anzahl, Reichweite und Raffinesse ihrer Angriffe zu erhöhen.

Was Ihre Mitarbeiter wissen sollten

Vertrauen Sie keinem Absender, auch wenn eine E-Mail von einer bekannten Person oder einer Behörde zu stammen scheint. Achten Sie auf weitere Anzeichen für Phishing wie Aufbau von Zeitdruck, unbekannte Absender, Diskrepanzen zwischen dem Anzeigenamen und der E-Mail-Adresse des Absenders oder Aufforderungen, Geld zu überweisen oder vertrauliche Daten preiszugeben.

Infografik zu generativer KI und Phishing-Ködern, die für Proofpoint Security Awareness-Kunden verfügbar ist.

Generative KI kann zu Datenlecks führen

Um die Produktivität zu steigern, laden manche Mitarbeiter ihre Arbeit auf GenAI-Websites hoch, die ihnen bei technischen Problemen, Rechtschreibfehlern oder bei der Datenanalyse helfen. In einigen Fällen handelt es sich dabei um vertrauliche Informationen wie Quellcode, Kundendaten, Produktionsprozesse oder geheime Rezepturen.

Den meisten Mitarbeitern ist nicht bewusst, dass GenAI-Websites und KI-Chatbots alle erhaltenen Informationen unter Umständen speichern und Entwickler mithilfe dieser Daten die KI-Chatbots trainieren und optimieren. Dadurch kann es zu einer versehentlichen Weitergabe vertraulicher Daten an andere Anwender innerhalb oder außerhalb des Unternehmens und damit zu potenziellen Datenkompromittierungen und Risiken für das geistige Eigentum kommen.

Was Ihre Mitarbeiter wissen sollten

Informationen, die in öffentlich zugängliche GenAI-Chatbots eingegeben werden, können in die Hände externer Personen gelangen. Vertrauliche Informationen oder Daten sollten also niemals auf eine GenAI-Website hochgeladen werden, da dies zum Verlust von geistigem Eigentum, zum Verstoß gegen gesetzliche Vorschriften und zur Kompromittierung von Daten führen kann.

GenAI-Halluzinationen können zu fehlerhaften Ergebnissen führen

GenAI-Chatbots scheinen praktisch ALLES zu wissen. Wenn man eine Frage eingibt, liefern sie immer Antworten, die zunächst plausibel erscheinen. Wenn ein Chatbot jedoch mit Daten trainiert wird, die nicht korrekt oder nicht neutral sind, können sich Fehler einschleichen. Was wäre zum Beispiel, wenn ein KI-Chatbot mit Daten trainiert würde, die suggerieren, dass die Erde flach ist?

KI-Modelle werden mit Daten trainiert, um darin Muster zu erkennen und Vorhersagen treffen zu können. Wenn ein KI-Chatbot mit unvollständigen oder einseitigen Daten trainiert wird, werden die erkannten Muster verzerrt, was dazu führt, dass der Chatbot ebenfalls verzerrte, unvollständige oder verfälschte Antworten gibt. Dies wird als KI-Halluzination bezeichnet. Hier sind einige Beispiele:

- Sachlich falsche Informationen: Die vom KI-Chatbot generierten Texte oder Aussagen scheinen auf den ersten Blick wahr zu sein, sind es aber nicht oder nur teilweise. Diese Form der KI-Halluzination kommt am häufigsten vor.

- Falschinformation: Generative KI erzeugt Falschinformationen über eine Organisation oder eine reale Person, indem sie wahre und falsche Fakten vermischt. Anwender könnten diese erfundenen Antworten für bare Münze nehmen.

- Fehlender Kontext: Ein KI-Chatbot generiert eine Antwort, ohne dem Anwender alle notwendigen Informationen zur Verfügung zu stellen. So kann es beispielsweise bei einer Frage nach der Unbedenklichkeit von Erdnussbutter dazu kommen, dass wichtige Informationen wie das Risiko einer allergischen Reaktion ausgelassen werden und der Anwender somit keine fundierte Entscheidung treffen kann.

Was Ihre Mitarbeiter wissen sollten

Seien Sie bei Informationen, die von einem KI-Chatbot stammen, immer vorsichtig. Recherchieren Sie selbst und überprüfen Sie alle Fakten, die der Chatbot als wahr darstellt. Denken Sie auch daran, dass viele KI-Chatbots nicht speziell dafür entwickelt wurden, wissenschaftliche Recherchen durchzuführen, Gesetze und Rechtsprechung zu zitieren oder das Wetter vorherzusagen. Auch wenn Sie eine Antwort erhalten, muss diese nicht korrekt sein.

Generative KI erleichtert die Erstellung von Deepfakes

Deepfakes sind gefälschte Bilder oder Videos, die von einer KI generiert wurden, wobei häufig Gesichter oder Stimmen ersetzt werden. Deepfakes werden mithilfe einer Form von Machine Learning, dem sogenannten Deep Learning, erstellt und waren bereits vor der Veröffentlichung von GenAI-Tools populär. Die Tools erleichtern jedoch die Erstellung von Deepfakes erheblich, da sie es ermöglichen, Inhalte mithilfe von Algorithmen auf Basis existierender Beispiele und Daten zu erstellen.

Cyberkriminelle nutzen Deepfakes inzwischen regelmäßig für ihre Angriffe, insbesondere wenn es gegen Großunternehmen geht. Sie imitieren damit beispielsweise deren CEO oder CFO, um betrügerische Überweisungen zu erzwingen.

Dank neuer Technologien wie GenAI lassen sich Deepfakes mit weniger manuellem und finanziellem Aufwand erstellen. Es ist daher nur eine Frage der Zeit, bis Angreifer sie gegen Unternehmen jeder Größe einsetzen. Leider gibt es bisher keine Technologie oder Lösung, die schädliche Deepfakes erkennen und stoppen kann. Am besten schützen Sie Ihr Unternehmen, indem Sie Ihre Mitarbeiter zu Deepfakes schulen und interne Strategien und Richtlinien zur Abwehr dieser Bedrohung entwickeln.

Was Ihre Mitarbeiter wissen sollten

Lassen Sie sich Aufträge und Anfragen immer über einen anderen Kommunikationskanal von der Person bestätigen, von der sie stammen. Bei einem Telefon- oder Videoanruf von einer bekannten Führungskraft oder Geschäftsperson, in dem Sie um die sofortige Erledigung eines Auftrages gebeten werden, sollte die Anweisung direkt von der betreffenden Person bestätigt werden. Dies sollte telefonisch oder, wenn möglich, persönlich erfolgen.

Die Quintessenz lautet also: Vertrauen Sie grundsätzlich niemandem und nutzen Sie Ihren gesunden Menschenverstand. Melden Sie dem Sicherheitsteam alles, was Ihnen etwas seltsam vorkommt.

Infografik zu KI-generierten Deepfakes, die für Proofpoint Security Awareness-Kunden verfügbar ist.

Integrieren Sie Anwenderschulungen in Ihre Sicherheitsmaßnahmen

Ein altes chinesisches Sprichwort ist eine weise Warnung: „Das Wasser kann ein Boot tragen, es aber auch zum Kentern bringen.“ Die Freude über den Komfort, den GenAI-Tools mit sich bringen, und die vielversprechenden Zukunftsperspektiven sind derzeit groß. Dennoch dürfen wir die Risiken, die mit dieser sich schnell verbreitenden Technologie verbunden sind, nicht außer Acht lassen.

Deshalb müssen Sie bei der Planung und Priorisierung von Abwehrmaßnahmen für GenAI-Bedrohungen auch an die Schulung Ihrer Anwender denken. Angesichts der zunehmenden Nutzung von KI-Chatbots ist es wichtig, dass Ihre Mitarbeiter mit den Vorteilen und Risiken generativer KI vertraut sind, damit sie sich selbst und das Unternehmen besser schützen können.

Der Cybersecurity-Awareness-Monat steht vor der Tür. Beginnen Sie jetzt mit den Vorbereitungen und berücksichtigen Sie dabei auch die Risiken, die generative KI mit sich bringt. Nehmen Sie am 14. und 28. August an unserer Webinar-Reihe teil, bei der Sie erfahren, wie Sie eine Kultur der Wachsamkeit fördern, die Ihre Mitarbeiter von passiven Zielen zu aktiven Verteidigern macht.