Vous n'ignorez sans doute plus que l'IA générative est une arme à double tranchant, étant donné qu'elle présente à la fois des opportunités et des risques. D'une part, l'IA générative améliore la productivité, notamment en matière de création de contenu, de résolution des problèmes, de recherche et d'analyse. D'autre part, elle crée divers risques de sécurité dont la plupart des utilisateurs n'ont pas encore pris conscience.

Cet article de blog examine les risques les plus courants associés à l'IA générative afin que vous puissiez y sensibiliser vos utilisateurs.

L'IA générative est utilisée pour créer des leurres convaincants

Les cybercriminels bénéficient indéniablement de l'IA générative, qui les aide à surmonter les barrières linguistiques, voire culturelles. Les recherches menées pour les besoins du rapport State of the Phish 2024 de Proofpoint révèlent que les attaques BEC se sont multipliées dans les pays non anglophones. Cette tendance s'explique en partie par l'essor de l'IA générative.

Auparavant, nous apprenions aux utilisateurs à faire attention aux fautes de grammaire et d'orthographe dans un email, car elles constituaient le signe évident d'une tentative de phishing. Ce n'est plus le cas.

En effet, l'IA générative permet de rédiger des messages de phishing de meilleure qualité. Les fautes de grammaire ne sont plus un indicateur fiable d'une tentative de phishing. Les équipes de recherche sur les cybermenaces estiment cependant que les messages de phishing les plus sophistiqués sont encore créés manuellement par les cybercriminels. La différence, c'est que les cybercriminels exploitent la puissance de l'IA générative pour amplifier le volume, l'échelle et la sophistication de leurs attaques.

Ce que vos collaborateurs doivent savoir

Ne faites confiance à aucun expéditeur, même si l'email semble provenir d'une personne que vous connaissez ou d'une autorité. Soyez attentif aux autres signes de phishing, tels qu'un sentiment d'urgence, un expéditeur inattendu, des discordances entre le nom d'affichage de l'expéditeur et l'adresse email, et une demande de paiement ou de données sensibles.

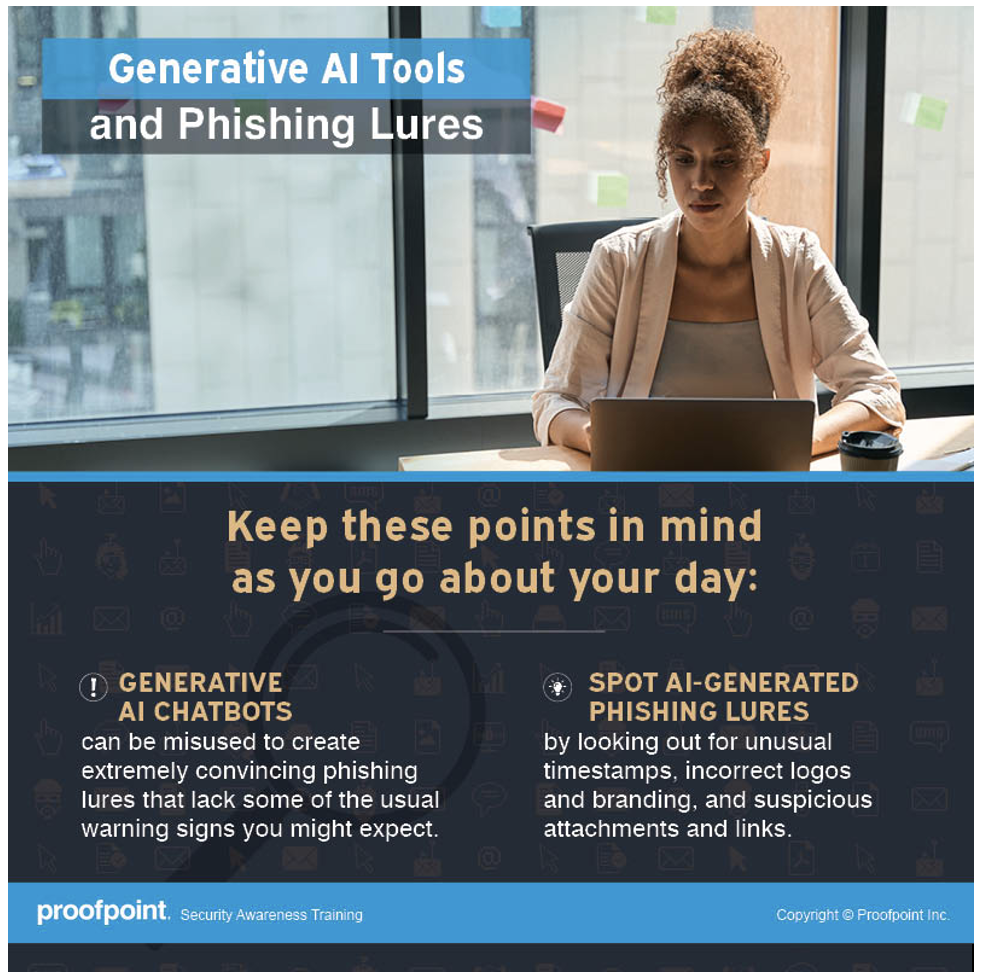

Infographie sur les outils d'IA générative et les leurres de phishing disponible avec Proofpoint Security Awareness.

L'IA générative peut être source d'une fuite de données

Pour améliorer leur productivité, certains utilisateurs téléchargent leur travail sur des sites d'IA générative afin d'obtenir une assistance technique, une aide à l'édition ou une analyse de données. Parfois, leur travail contient des informations sensibles telles que du code source, des informations sur les clients, un processus de production ou une recette secrète.

Ce que la plupart des gens ignorent, c'est que ces sites d'IA générative ou ces chatbots d'IA peuvent stocker toutes les informations qui leur sont communiquées. Les développeurs entraînent les chatbots d'IA à l'aide des données et des réponses fournies par les utilisateurs afin d'améliorer leurs performances. Par conséquent, ces chatbots pourraient accidentellement partager des données sensibles avec d'autres utilisateurs, qu'ils soient internes ou extérieurs à l'entreprise, ce qui pourrait potentiellement entraîner des compromissions de données et présenterait un risque pour la propriété intellectuelle.

Ce que vos collaborateurs doivent savoir

Tout ce que vous partagez avec un chatbot public d'IA générative peut être partagé avec d'autres personnes. Veillez donc à ne pas communiquer d'informations sensibles ou télécharger des données sensibles sur un site d'IA générative. Cela pourrait entraîner une perte de propriété intellectuelle, des violations de la réglementation et des compromissions des données.

Les réponses de l'IA générative ne sont pas toujours fiables en raison des hallucinations

Les chatbots d'IA générative semblent TOUT savoir. Lorsque vous posez une question, ils vous donnent toujours des réponses qui semblent sensées. Toutefois, si un chatbot est entraîné à partir de données inexactes ou biaisées, les informations qu'il génère peuvent être erronées. Par exemple, imaginons qu'un chatbot d'IA soit entraîné à partir de données suggérant que la Terre est plate.

Les modèles d'IA sont entraînés à partir de données pour pouvoir identifier des modèles et faire des prédictions. Si un chatbot d'IA est entraîné à partir de données incomplètes ou biaisées, il identifiera des modèles incorrects et générera des informations inexactes, incomplètes ou biaisées. Ce phénomène est appelé hallucination d'IA. Par exemple :

- Informations incorrectes. La réponse générée par le chatbot d'IA semble vraie alors qu'elle ne l'est pas (ou qu'elle ne l'est que partiellement). Il s'agit de l'une des formes d'hallucination d'IA les plus courantes.

- Désinformation. L'IA générative génère de fausses informations sur une entité ou une personne réelle, en introduisant des éléments d'information erronés. Certains utilisateurs peuvent prendre ces informations inventées de toutes pièces pour la vérité.

- Contexte incomplet. Un chatbot d'IA peut générer une réponse générale sans donner aux utilisateurs toutes les informations dont ils ont besoin. Par exemple, si quelqu'un demande si on peut manger du beurre de cacahuètes sans danger, le chatbot peut ne pas fournir suffisamment de détails pour aider la personne à prendre une décision (risque de réaction allergique aux cacahuètes, par exemple).

Ce que vos collaborateurs doivent savoir

Restez sceptique vis-à-vis de toutes les informations provenant d'un chatbot d'IA. Effectuez vos propres recherches à partir d'autres sources et vérifiez l'exactitude de toutes les informations présentées comme vraies par les chatbots. En outre, n'oubliez pas que de nombreux chatbots d'IA ne sont pas conçus pour des utilisations spécifiques telles que la recherche scientifique, la citation de lois et d'affaires ou les prévisions météorologiques. Vous obtiendrez toujours une réponse, mais elle ne sera peut-être pas exacte.

L'IA générative facilite la création de deepfakes

Les deepfakes sont de fausses images ou vidéos générées par l'IA et manipulées pour remplacer le visage ou la voix d'une personne. Elles sont générées par un type d'apprentissage automatique appelé « apprentissage profond » (deep learning). Bien que les deepfakes soient apparus avant la généralisation des outils d'IA générative, ces derniers permettent de créer des deepfakes très facilement puisque l'IA générative utilise des algorithmes pour générer du contenu basé sur des exemples et données existants.

Les deepfakes sont devenus une arme redoutable pour les cybercriminels qui souhaitent lancer des attaques, en particulier à l'encontre de grandes entreprises. Les cybercriminels peuvent par exemple utiliser des deepfakes pour se faire passer pour des dirigeants tels que le PDG ou le directeur financier de l'entreprise et obtenir l'exécution de paiements frauduleux.

Les technologies émergentes telles que l'IA générative permettent de créer facilement des deepfakes à moindres frais. Il ne fait donc aucun doute que les cybercriminels finiront tôt ou tard par les utiliser pour cibler des entreprises de toutes tailles. Malheureusement, il n'existe pas de technologie ou de solution capable de détecter et de neutraliser efficacement les deepfakes malveillants. La meilleure solution est de sensibiliser vos collaborateurs aux deepfakes, de mettre en place un processus interne et de créer des règles de prévention.

Ce que vos collaborateurs doivent savoir

Confirmez toujours la demande auprès de son auteur par un autre canal. Si un collaborateur reçoit un appel téléphonique ou vidéo d'un dirigeant ou d'un professionnel connu lui demandant de faire quelque chose immédiatement, il est recommandé de vérifier la requête auprès de cette personne via une ligne téléphonique directe (en personne, si possible).

En résumé : ne faites confiance à personne. Faites preuve de bon sens. Si quelque chose vous semble bizarre, signalez-le à l'équipe de sécurité.

Infographie sur les deepfakes générés par l'IA disponible avec Proofpoint Security Awareness.

Intégrez la formation des utilisateurs à votre stratégie de sécurité

Un vieux proverbe chinois nous met en garde : « L'eau qui porte le bateau est la même qui l'engloutit. » Dans notre monde actuel, les avantages de l'IA générative et l'avenir prometteur qu'elle semble annoncer sont accueillis avec beaucoup d'enthousiasme. Il ne faut cependant pas négliger les risques associés à cette technologie émergente.

Lors de l'élaboration de votre stratégie de réduction des risques liés à l'IA générative et de la hiérarchisation de vos efforts de sécurité, veillez à intégrer la formation des utilisateurs à vos plans. Face à la généralisation des chatbots d'IA, vos collaborateurs doivent être informés des avantages comme des risques de l'IA générative pour mieux se protéger et protéger votre entreprise.

Le mois de la sensibilisation à la cybersécurité approche. Commencez à planifier dès maintenant votre programme de formation et assurez-vous d'y intégrer les risques de l'IA générative. Pour découvrir comment favoriser une culture de la vigilance qui permettra de transformer vos utilisateurs de cibles passives en défenseurs actifs, assistez à notre série spéciale de webinaires les 14 et 28 août.