Ormai forse saprai che l'intelligenza artificiale generativa è un'arma a doppio taglio: presenta sia opportunità sia rischi. Da un lato, l'IA generativa aumenta la produttività, soprattutto quando si tratta di creare contenuti, risolvere dei problemi, svolgere ricerche e analisi. Dall'altro, pone diversi rischi per la sicurezza che ancora non vengono compresi appieno.

In questo post del blog esploreremo i rischi più comuni associati all'intelligenza artificiale generativa, in modo che tu possa formare di conseguenza i tuoi utenti.

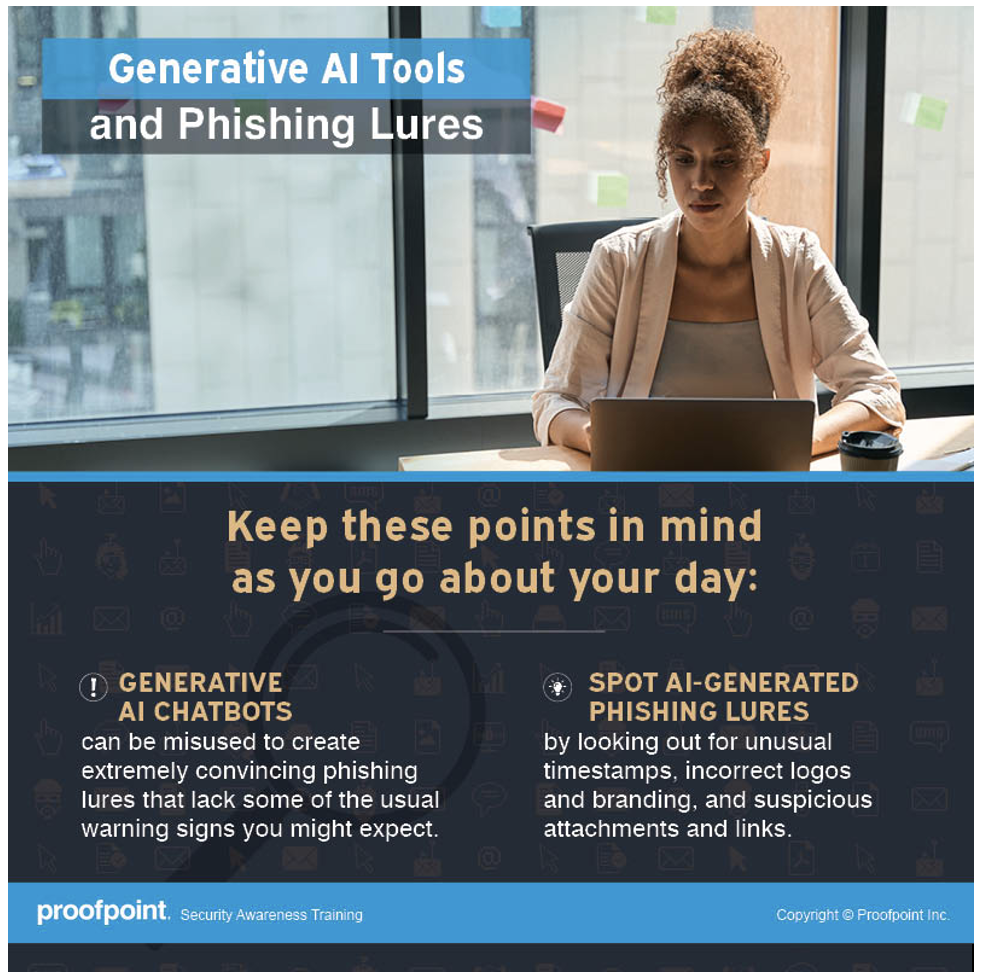

L'uso dell'IA generativa per creare delle esche convincenti

A trarre vantaggio dall'IA generativa sono di certo i criminali informatici, che così possono superare le barriere linguistiche e persino culturali. La ricerca per il rapporto State of the Phish del 2024 di Proofpoint ha rilevato che la diffusione degli attacchi BEC (Business Email Compromise, violazione dell’email aziendale) è aumentata nei paesi in cui non si parla inglese. Una delle ragioni di questa tendenza è l'ascesa dell'intelligenza artificiale generativa.

Un tempo spiegavamo alle persone di fare attenzione alla grammatica e agli errori di ortografia nelle email, perché sono i segnali più evidenti di un tentativo di phishing. Ora non più.

Grazie all'IA generativa i messaggi di phishing sono diventati più elaborati. Gli errori grammaticali non sono più un forte indicatore di phishing. I team di ricerca sulle minacce informatiche sostengono che i messaggi di phishing più sofisticati vengono ancora creati manualmente dai malintenzionati. Il problema è che ora quest'ultimi attingono alla potenza dell'IA generativa per aumentare il volume, la scala e la complessità dei loro attacchi.

Cosa devono sapere i tuoi dipendenti

Non fidarsi di nessun mittente, anche se l'email sembra provenire da qualcuno che si conosce o da una persona autorevole. Prestare molta attenzione agli altri segni del phishing, come il senso di urgenza, un mittente inaspettato, incongruenze fra il nome visualizzato e l'indirizzo email del mittente e una richiesta di pagamento o di dati sensibili.

Infografica sull'IA generativa e le esche del phishing disponibile con Proofpoint Security Awareness.

L'intelligenza artificiale generativa può provocare la perdita dei dati

Per essere più produttivi, alcuni caricano il proprio lavoro sui siti dell'IA generativa per avere assistenza tecnica, aiuto per una revisione o per l'analisi dei dati. A volte tali materiali di lavoro includono dati sensibili come codice sorgente, informazioni sui clienti, processi produttivi o formule segrete.

Ciò che la maggior parte delle persone non sa è che questi siti o i chatbot di IA possono memorizzare qualsiasi informazione venga a essi fornita. Al fine di migliorarne le prestazioni, gli sviluppatori addestrano i chatbot di IA con le richieste e risposte degli utenti. Di conseguenza i chatbot potrebbero condividere accidentalmente dati sensibili con altri utenti, sia all'interno sia all'esterno della tua organizzazione, causando potenziali violazioni dei dati e mettendo a rischio la proprietà intellettuale.

Cosa devono sapere i tuoi dipendenti

Tutto ciò che si condivide con un chatbot pubblico basato sull'IA generativa potrebbe venir condiviso con altri. Bisogna fare attenzione a non comunicare nessuna informazione sensibile e a non caricare alcun dato sensibile nei siti dell'IA generativa. In caso contrario si potrebbe perdere la proprietà intellettuale, infrangere delle normative e subire la violazione dei dati.

L'intelligenza artificiale generativa può avere delle allucinazioni, perciò i risultati non sono sempre affidabili

I chatbot basati sull'IA generativa danno l'impressione di sapere TUTTO. Quando immetti una domanda, ti vengono sempre fornite delle risposte che sembrano avere senso. Tuttavia, se un chatbot viene addestrato con dati imprecisi o distorti, qualsiasi informazione generata può essere oggettivamente errata. Ad esempio, immaginiamo un chatbot di intelligenza artificiale addestrato con dei dati che suggeriscono che la Terra è piatta.

I dati di addestramento premettono ai modelli di intelligenza artificiale di individuare gli schemi e fare delle previsioni. Se un chatbot di IA viene addestrato con dati incompleti o tendenziosi, sceglierà schemi errati generando informazioni inaccurate, incomplete o distorte. Questo fenomeno è detto allucinazione dell'intelligenza artificiale. Esempi più comuni:

- Informazioni oggettivamente errate. Il testo o l'affermazione generati da un chatbot di intelligenza artificiale sembrano veri ma non lo sono (o lo sono solo in parte). Questa è una delle forme più comuni di allucinazione.

- Disinformazione. L'IA generativa fornisce informazioni false su un'entità o su una persona reale, aggiungendo dati non veritieri. Alcuni utenti potrebbero prendere per vere tali false affermazioni.

- Mancanza del contesto. Un chatbot dotato di intelligenza artificiale può produrre un'affermazione generica senza fornire agli utenti tutte le informazioni di cui hanno bisogno. Ad esempio, se qualcuno chiede se si può mangiare il burro di arachidi senza rischi, il chatbot potrebbe non fornire un dettaglio come il rischio di una reazione allergica alle noccioline, necessario per prendere una decisione soggettiva.

Cosa devono sapere i tuoi dipendenti

Essere scettici verso tutte le informazioni provenienti da un chatbot di IA. Consultare anche altre fonti e verificare la veridicità di qualsiasi cosa affermata dai chatbot. Inoltre, tenere presente che molti chatbot basati sull'intelligenza artificiale non sono progettati per usi specifici, come lo svolgimento di ricerche scientifiche, la citazione di leggi e casi o le previsioni del tempo. Benché si riceva una risposta, potrebbe non essere precisa.

L'IA generativa facilita la creazione dei deepfake

I deepfake, o falsi profondi, sono immagini o video fasulli generati dall'IA, che sono stati manipolati sostituendo il volto o la voce di una persona. Vengono prodotti da un tipo di machine learning (apprendimento automatico) detto deep learning (apprendimento profondo). Sebbene i deepfake siano comparsi prima che gli strumenti di IA generativa si diffondessero, quest'ultimi ne facilitano molto la creazione, poiché l'IA generativa utilizza degli algoritmi per produrre contenuti basati su esempi e dati esistenti.

Nelle mani dei criminali informatici i deepfake sono un'arma preziosa per sferrare i loro attacchi, soprattutto contro le grandi aziende. Ad esempio, tramite i deepfake gli aggressori possono impersonare un dirigente di azienda, come un amministratore delegato o un direttore finanziario, per indurre pagamenti fraudolenti.

Le tecnologie emergenti come l'IA generativa rendono più semplice ed economica la creazione dei deepfake, quindi è solo questione di tempo prima che i criminali inizino a prendere di mira aziende di tutte le dimensioni. Purtroppo non esiste una tecnologia o una soluzione in grado di rilevare e fermare efficacemente i deepfake ostili. Il modo migliore è quello di formare i dipendenti sui deepfake, di stabilire una procedura interna e di creare delle politiche di mitigazione.

Cosa devono sapere i tuoi dipendenti

Confermare sempre una richiesta con il richiedente tramite un canale diverso. Se qualcuno riceve una telefonata o una videochiamata da un noto dirigente o professionista, che chiede di fare qualcosa immediatamente, è consigliabile verificare con la persona in questione chiamandola al numero telefonico diretto (di persona, se possibile).

La morale della favola? Non fidarti di nessuno. Usa il buon senso. Se qualcosa ti sembra strano, segnalalo al reparto sicurezza.

Infografica sui deepfake prodotti dall'IA generativa disponibile con Proofpoint Security Awareness.

Rendere la formazione degli utenti parte integrante delle attività legate alla sicurezza

Un antico proverbio cinese recita saggiamente: “L’acqua che sostiene la barca può anche sommergerla.” Nel mondo di oggi regna l'entusiasmo per la praticità offerta dall'intelligenza artificiale generativa e per il futuro promettente che sembra preannunciare. Tuttavia è fondamentale non sottovalutare i rischi associati a questa tecnologia in rapida ascesa.

Quando si elaborano le strategie e si stabiliscono le priorità delle attività di sicurezza per affrontare i rischi dell'IA generativa, bisogna assicurarsi di includere la formazione degli utenti. Con la crescente adozione dei chatbot basati sull'intelligenza artificiale, i tuoi dipendenti devono conoscere i vantaggi e i rischi dell'IA generativa, in modo da poter proteggere meglio sé stessi e la tua azienda.

Il Mese di sensibilizzazione alla sicurezza informatica si avvicina. Inizia a pianificarlo fin da ora assicurandoti di includere nel programma i rischi dell'intelligenza artificiale generativa. Per saperne di più su come promuovere una cultura di vigilanza che trasformi le persone da bersagli passivi in difensori attivi, partecipa alla nostra serie di webinar speciali il 14 e il 28 agosto.