A estas alturas, probablemente sepa que la IA generativa (GenAI) es un arma de doble filo: plantea oportunidades y riesgos. Por un lado, mejora la productividad, sobre todo en lo que se refiere a la creación de contenidos, la resolución de problemas y la investigación y el análisis. Por otro lado, crea varios riesgos de seguridad que los usuarios aún no han terminado de asimilar.

En este artículo de blog, vamos a analizar los riesgos más comunes asociados a la IA generativa, para que pueda formar adecuadamente a sus usuarios.

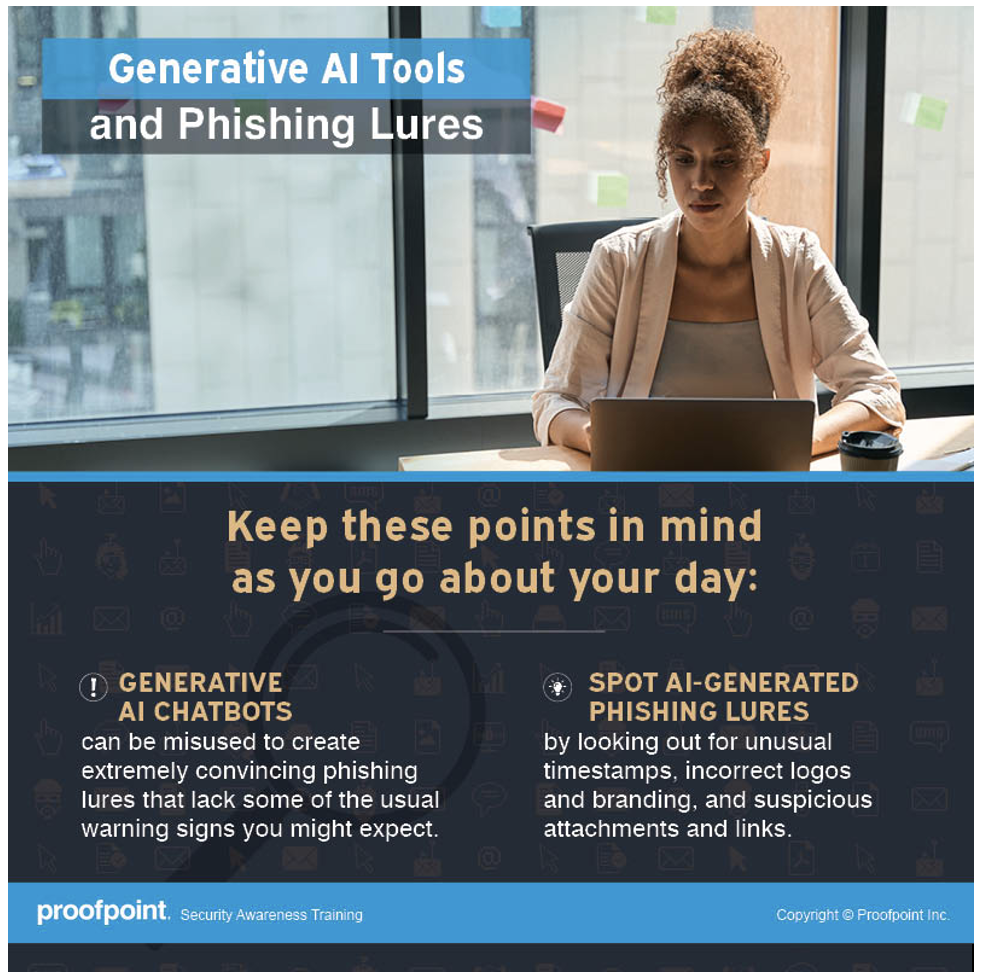

La IA generativa se utiliza para crear señuelos convincentes

Los ciberdelincuentes aprovechan la IA generativa porque les ayuda a superar las barreras lingüísticas e incluso las culturales. El estudio realizado en el marco del informe State of the Phish 2024 de Proofpoint descubrió que los ataques Business Email Compromise (BEC) se han hecho más prevalentes en países no angloparlantes. Algo que explica esa tendencia es el auge de la IA generativa.

En su día, enseñábamos a los usuarios a prestar atención a las faltas de ortografía y los errores gramaticales en mensajes de correo electrónico porque suelen ser indicios obvios de phishing. Esto ha dejado de ser así.

Con la IA generativa, los mensajes de phishing se han vuelto más elaborados. Los errores gramaticales han dejado de ser un claro indicador de phishing. Los investigadores de amenazas estarían de acuerdo en que los ciberdelincuentes siguen creando manualmente los mensajes de phishing más sofisticados. Lo que ocurre es que ahora los atacantes han aprovechado el poder de la IA generativa para aumentar el volumen, amplitud y sofisticación de sus ataques.

Lo que su personal debería saber

No se fíe de ningún remitente, incluso si el mensaje de correo electrónico procede de alguien que conoce o de alguna autoridad. Preste atención a otros indicios de phishing, como una sensación de urgencia, un remitente no esperado, incoherencias entre el nombre mostrado y la dirección de correo electrónico, y una solicitud de pago o de datos sensibles.

Infografía sobre IA generativa y señuelos de phishing disponible con Proofpoint Security Awareness.

La IA generativa puede ser una fuente de filtraciones de datos

Para aumentar la productividad, algunas personas suben su trabajo a sitios de IA generativa, en busca de ayuda técnica o de edición o análisis de datos. En ocasiones, su trabajo incluye información confidencial, como código fuente, información de clientes o un proceso de producción o receta secreta.

Lo que muchos desconocen es que estos sitios de IA generativa o chatbots de IA pueden almacenar toda la información que se comparte con ellos. Los desarrolladores entrenan a los chatbots de IA con aportaciones y respuestas de los usuarios para mejorar su rendimiento. En consecuencia, estos chatbots podrían compartir datos sensibles, dentro o fuera de la organización, lo que puede dar lugar a posibles filtraciones de datos, con el consiguiente riesgo para la propiedad intelectual.

Lo que su personal debería saber

Todo lo que comparte con un chatbot de IA generativa público es susceptible de compartirse con otros. Tenga cuidado de no compartir información confidencial o cargar datos sensibles en un sitio de IA generativa. Esto podría generar una pérdida de propiedad intelectual, incumplimientos normativos y fugas de datos.

Las alucinaciones de IA generativa significan que los resultados no son siempre fiables

Los chatbots de IA generativa parecen saberlo TODO. Cuando introduce una pregunta, siempre tienen una respuesta que parece tener sentido. Sin embargo, si un chatbot está entrenado con datos imprecisos o sesgados, toda la información que genere puede ser objetivamente errónea. Por ejemplo, imagínese un chatbot de IA que esté entrenado con datos que sugieran que la Tierra es plana.

Los modelos de IA se entrenan con datos que permiten encontrar patrones para realizar predicciones. Si un chatbot de IA está entrenado con datos incompletos o sesgados, recoge patrones incorrectos y genera información imprecisa, incompleta o sesgada. Esto se conoce como una alucinación de IA. Algunos ejemplos son:

- Información objetivamente incorrecta. El texto o afirmación generada por un chatbot de IA parece verdadero cuando no lo es (o es parcialmente cierto). Esta es una de las formas más comunes de alucinación de IA.

- Desinformación. La IA generativa genera información falsa sobre una entidad o una persona real, mezclando elementos de información falsa. Algunos usuarios pueden dar veracidad a esas indicaciones inventadas.

- No proporcionar todo el contexto. Un chatbot de IA puede generar un enunciado general sin ofrecer a los usuarios toda la información que necesitan. Por ejemplo, si alguien pregunta si es seguro comer mantequilla de cacahuete, puede que el chatbot no ofrezca suficientes detalles, como el riesgo de una reacción alérgica a los cacahuetes, que ayuden a la persona a hacer un juicio de valor.

Lo que su personal debería saber

Sea escéptico ante toda información procedente de un chatbot de IA. Investigue por su cuenta de otras fuentes y realice una verificación de los hechos de todo lo que los chatbots afirmen que sea cierta. Además, recuerde que muchos chatbots de IA no están diseñados para usos específicos, como llevar a cabo investigaciones científicas, citas de leyes y casos, o predecir el tiempo. Aun así recibirá una respuesta, pero puede que no sea precisa.

La IA generativa facilita la creación de deepfakes

Los deepfakes son imágenes o vídeos falsos generados mediante IA que se manipulan para sustituir la cara o la voz de una persona. Se generan mediante un tipo de aprendizaje automático llamado aprendizaje profundo (o deep learning). Mientras que los deepfakes surgieron antes de que se hicieran populares las herramientas de IA generativa, esas herramientas facilitan mucho el diseño de deepfakes ya que la IA generativa utiliza algoritmos para generar contenido basado en ejemplos y datos existentes.

Los deepfakes se han convertido en una fantástica arma para los ciberdelincuentes para lanzar ataques, sobre todo contra grandes empresas. Por ejemplo, los atacantes pueden hacerse pasar por ejecutivos como el CEO o el CFO de la empresa y utilizar deepfakes para obligar a realizar pagos fraudulentos.

La nueva tecnología, como la IA generativa, facilita el diseño de deepfakes y lo hace más barato, por lo que es solo cuestión de tiempo antes de que los ciberdelincuentes empiecen a atacar a empresas de todos los tamaños. Y, desafortunadamente, no existe una tecnología o solución capaz de detectar o bloquear eficazmente los deepfakes maliciosos. La mejor opción es formar a los empleados sobre ellos, establecer un proceso interno y crear políticas de mitigación.

Lo que su personal debería saber

Valide siempre la solicitud con el solicitante a través de un canal diferente. Si recibe una llamada telefónica o de vídeo de un líder o profesional bien conocido que le pide que haga algo inmediatamente, se recomienda que lo compruebe con esa persona a través de una línea de teléfono directa (o, si es posible, en persona).

Conclusión: No se fíe de nadie. Use el sentido común. Si algo parece extraño, comuníquelo al equipo de seguridad.

Infografía sobre deepfakes mediante IA generativa disponible con Proofpoint Security Awareness.

Convierta la formación de los usuarios en parte de sus iniciativas de seguridad

Hay un viejo proverbio chino que advierte con sabiduría: "El agua hace flotar el barco, pero también puede hundirlo". En nuestro mundo actual, abunda el entusiasmo por la comodidad que aporta la IA generativa y el futuro prometedor que parece presagiar. Sin embargo, resulta crucial no pasar por alto los riesgos asociados con esta tecnología de rápido crecimiento.

Al planificar y priorizar sus iniciativas de seguridad para hacer frente a los riesgos de la IA generativa, asegúrese de que la formación de los usuarios forma parte del plan. A medida que aumenta la adopción de los chatbots de IA, sus empleados necesitan aprender las ventajas y los riesgos de la IA generativa, para que puedan protegerse a sí mismos y a sus empresas.

Se acerca el mes para la concienciación en ciberseguridad. Empiece a planificar ahora y asegúrese de incorporar los riesgos de la IA generativa en su programa. Para obtener más información sobre cómo instaurar una cultura de vigilancia que transforme a sus empleados de objetivos pasivos a defensores activos, participe con nosotros en nuestra serie de webinars especiales del 14 al 28 de agosto.